Pytorch 卷积与梯度反向传播

pytorch计算图

https://zhuanlan.zhihu.com/p/33378444

https://zhuanlan.zhihu.com/p/69175484 这篇写的比较全,光说不练,假把式;光练不说,傻把式;连说带练~~真!把!式!’”

https://blog.csdn.net/cedi9117/article/details/106955001/ pytorch tensor计算

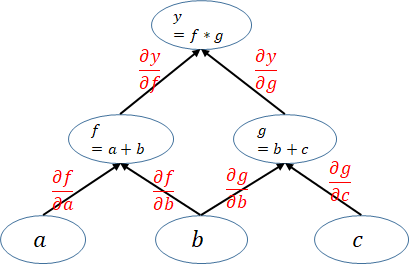

将梯度想象为小格子,因此同一层节点梯度是相加的,不同层的节点梯度是相乘的

理解一下

$$

z = f + g \

dz = k(df + dg) \

z = f * g * h \

z + dz = (f + df)(g + dg)(h + dh) 忽略高阶项

$$

https://zhuanlan.zhihu.com/p/27783097

Pytorch是利用Variable与Function来构建计算图的。Variable就像是计算图中的节点,保存计算结果(包括前向传播的激活值,反向传播的梯度),而Function就像计算图中的边,实现Variable的计算,并输出新的Variable。

torch.autograd.Funtion

矩阵求导

https://zhuanlan.zhihu.com/p/262751195

利用pytorch实现卷积运算 https://zhuanlan.zhihu.com/p/349683405,爱因斯坦求和标记